AI 目前是各家未來宏圖大業的重中之重,為了完成這些目標,現階段最重要的,就是搶到足夠多的高階 GPU。專家估算,當前爭奪最烈的離不開 5 家巨頭:微軟 (MSFT-US)、Google(GOOGL-US)、Meta(META-US)、亞馬遜 (AMZN-US) 與馬斯克創建的 xAI。

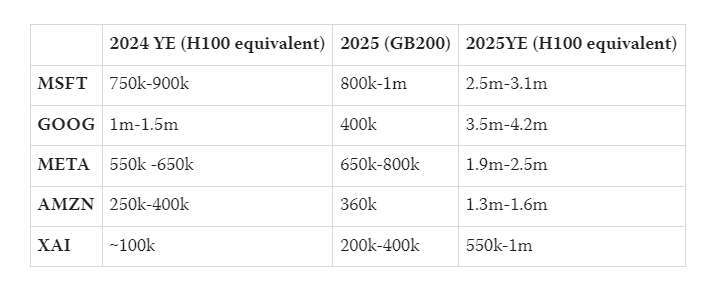

近日,LessWrong 網站上,作者 CharlesD 針對世界五大科技公司的 2024 年擁有的算力,以及 2025 年的預測,做出以下估算:

- 微軟有 75 萬 - 90 萬塊等效 H100,明年預計達到 250 萬 - 310 萬

- Google 有 100 萬 - 150 萬塊等效 H100,明年預計達到 350 萬 - 420 萬

- Meta 有 55 萬 - 65 萬塊等效 H100,明年預計達到 190 萬 - 250 萬

- 亞馬遜有 25 萬 - 40 萬塊等效 H100,明年預計達到 130 萬 - 160 萬

- xAI 有 10 萬塊等效 H100,明年預計達到 55 萬 - 100 萬

文章對此做出更進一步說明。

輝達的實際產量

文章指出,輝達 (NVDA-US) 是資料中心 GPU 的最大生產商。公司 2024 年的產量,目前,關於這項數據來源較少,有些甚至還對不上。不過,有估算表示 2024 年第四季將生產約 150 萬塊 Hopper GPU。

另外,據估計,2025 年輝達銷量為 650 萬至 700 萬塊 GPU,幾乎全是最新的 Hopper 和 Blackwell 系列。根據生產比例和產量預期,其中約包括 200 萬塊 Hopper,500 萬塊 Blackwell。

在這之前,根據估計,微軟和 Meta 在 2023 年各生產了 15 萬台 H100,考慮到 Nvidia 資料中心的收入,2023 年 H100 的同等產量似乎有可能達到 100 萬台。

微軟、Meta

微軟很可能就是輝達這兩年的最大客戶,這項判斷是基於以下幾個因素:

首先,微軟擁有全球最大的公有雲服務平台之一;其次,它是 OpenAI 的主要算力供應商;再者,與 Google、亞馬遜不同,微軟沒有大規模部署自己的客製化晶片;最後,微軟似乎與輝達建立了特殊的合作關係—他們是首個獲得 Blackwell GPU 的公司。

2024 年微軟的營收占比數據沒有 2023 年那麼精確,輝達第二季財報(10-Q)中提到上半年為 13%,第三季僅「超過 10%」。這表明,微軟在輝達銷售中的份額較 2023 年有所降低。

不過,Meta 曾發文宣稱,到 2024 年底將擁有相當於 60 萬塊 H100 算力。據稱這包括 35 萬塊 H100,剩餘部分很可能是 H200,以及少量將在最後一個季度交付的 Blackwell 晶片。

文章假設這 60 萬的數字準確無誤,並結合收入占比進行推算,便可以更準確地估計微軟的可用算力。微軟預計將比 Meta 高出 25%到 50%,也就是相當於 75 萬—90 萬塊等效 H100 算力。

Google、亞馬遜

僅從輝達營收的貢獻來看,亞馬遜、Google 無疑是落後微軟 Meta。然而,這兩家公司的情況有著顯著差異。

Google 已經擁有大量自研的客製化 TPU,這是內部工作負載的主要運算晶片。

而且,Google 在基礎建設的投入,只會越來越多。 2024 年第三季財報估計,AI 支出為 130 億美元,「大部分」用於建造技術基礎設施,其中 60% 是伺服器(GPU/TPU)。

大部分或許意味著 70-110 億美元,其中在 TPU/GPU 伺服器上預估耗資 45-70 億美元。

相比之下,亞馬遜內部 AI 工作負載規模很可能小得多。

他們持有相當數量的輝達晶片,主要是為了滿足透過其雲端平台提供的外部 GPU 需求,尤其是為 Anthropic 提供算力需求。

在 2024 年第三季財報電話會議上,亞馬遜 CEO Andy Jassy 在談到 Trainium2 時表示,這些晶片獲得了巨大的市場興趣,我們已多次與製造合作夥伴協商,大幅提高原定的生產計劃。

Semianalysis 報告指出,「根據我們已知數據,微軟和 Google 於 2024 年在 AI 基礎設施上的投資計劃,大幅領先亞馬遜部署的算力」。

這些晶片換算成等效 H100 並不明確,關於 Trainium/Trainium2 晶片的具體數量也難以獲得,僅知道在上述免費額度計劃中提供了 4 萬塊。

xAI

今年,xAI 在基礎建設中,最為標誌性事件便是──122 天建成了 10 萬塊 H100 組成的世界最大超算。

而且,這一規模還在不斷擴展中。馬斯克預告了未來將擴展到 20 萬塊由 H100/H200 組成的超算。

lesswrong 預計在 2025 年,Meta 的支出規模將維持在微軟支出的約 80% 水準。

雖然沒有提及 xAI,但馬斯克宣稱,將在 2025 年夏天部署一個有 30 萬塊 Blackwell 晶片的運算集群。

文章考慮到馬斯克一貫的誇張風格,更為合理的一個估計是,到 2025 年底他們可能實際擁有 20 萬 - 40 萬塊晶片。